好久没更新论文的分享了,今天来给大家分享一篇最近阅读的个人感觉非常有价值的一篇:MEMGPT: TOWARDS LLMS AS OPERATING SYSTEMS。我们都知道无论是ChatGPT、LLaMA、Claude等等大模型,虽然支持结合上下文进行对话,但这个对话长度实际是受限的,尤其是如果想进行长文档处理的时候就更头疼了,那么对于大模型这种…

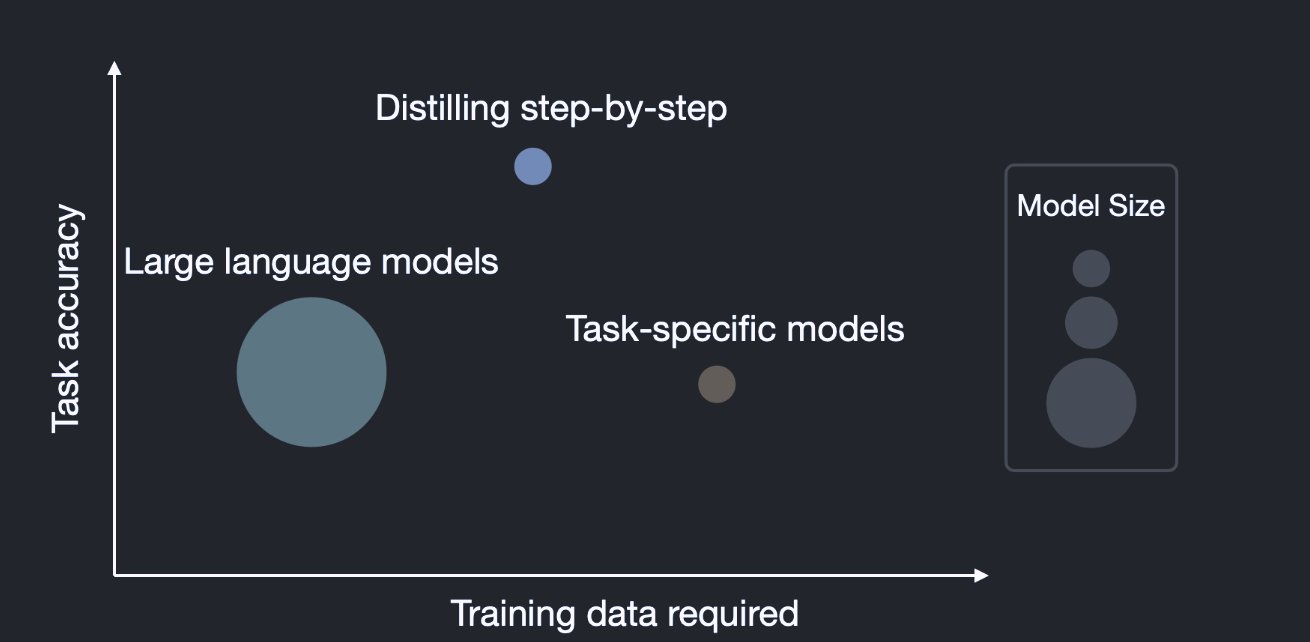

如今国际上各种大语言模型蜂拥而至,但我们个人或者小公司想玩一个大模型要么花钱买硬件要么花钱买服务,因为大型语言模型(LLMs)虽然厉害,但部署起来非常困难!此外,这些巨型语言模型就像是那些吃不胖的人,吃了无数的数据,练了无数的参数,但是一到要“出门”工作的时候,问题来了。它们需要的计算资源和内存就像是一个永无止境的黑洞,让人望而却步。 今天我要讲的…

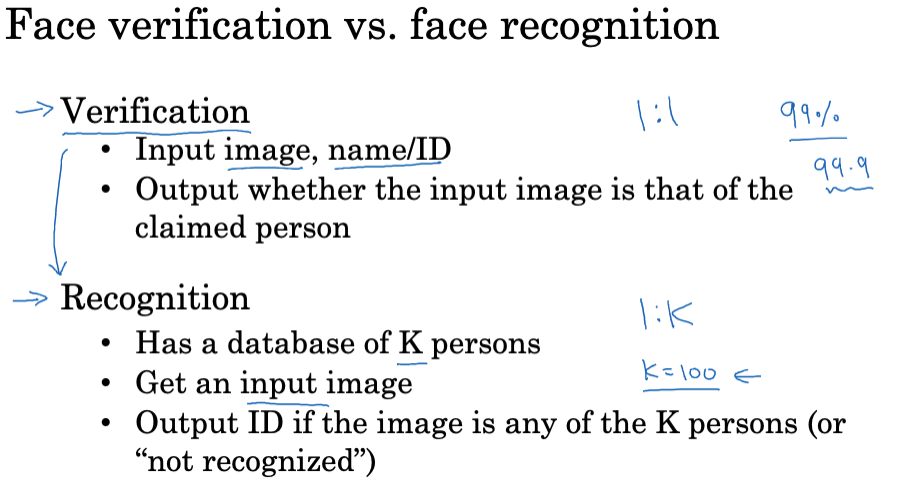

终于来到Andrew Ng教授深度学习专项课程CNN课程的的最后一节课的笔记博客了,这也是这门课程专栏的最后一篇博文了,本篇主要内容主要是CNN在人脸识别和神经风格迁移中的应用。那我们开始吧! 人脸识别 人脸识别简介 什么是人脸识别?我想大家应该都使用过人脸识别的系统,比如一些办公楼或者小区的人脸识别系统,系统可以识别到一个活生生的人脸(相比于照片…

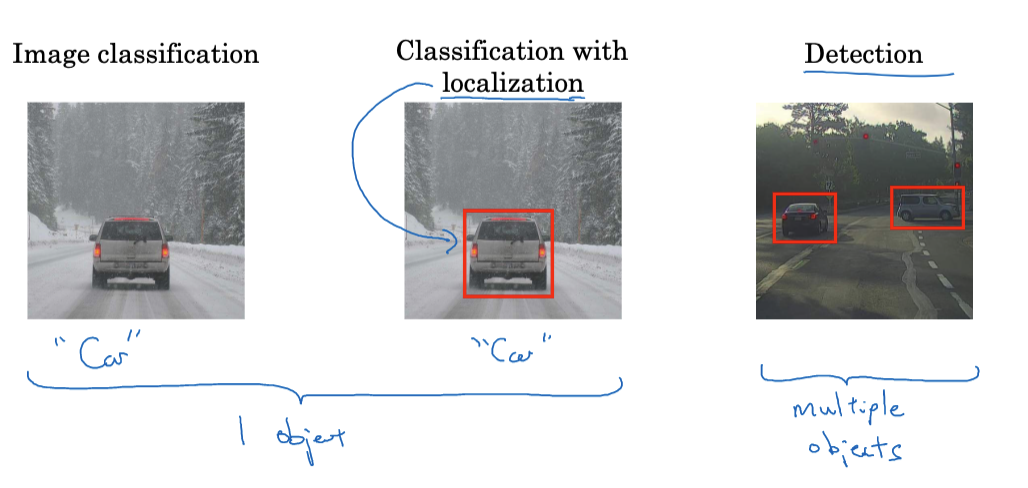

图像处理算法发展迅速,卷积神经网络扮演越来越重要的角色。本文基于Andrew Ng 教授的深度学习专项课程第四门课程的第三周内容来详细介绍卷积神经网络(CNN)中的主要检测算法,包括对象识别定位、如何提升检测精度,YOLO算法,语义分割等概念。 对象的识别与定位 计算机视觉的核心挑战之一是如何使机器能够“看到”和“理解”图像中的内容。不同于人类直观…

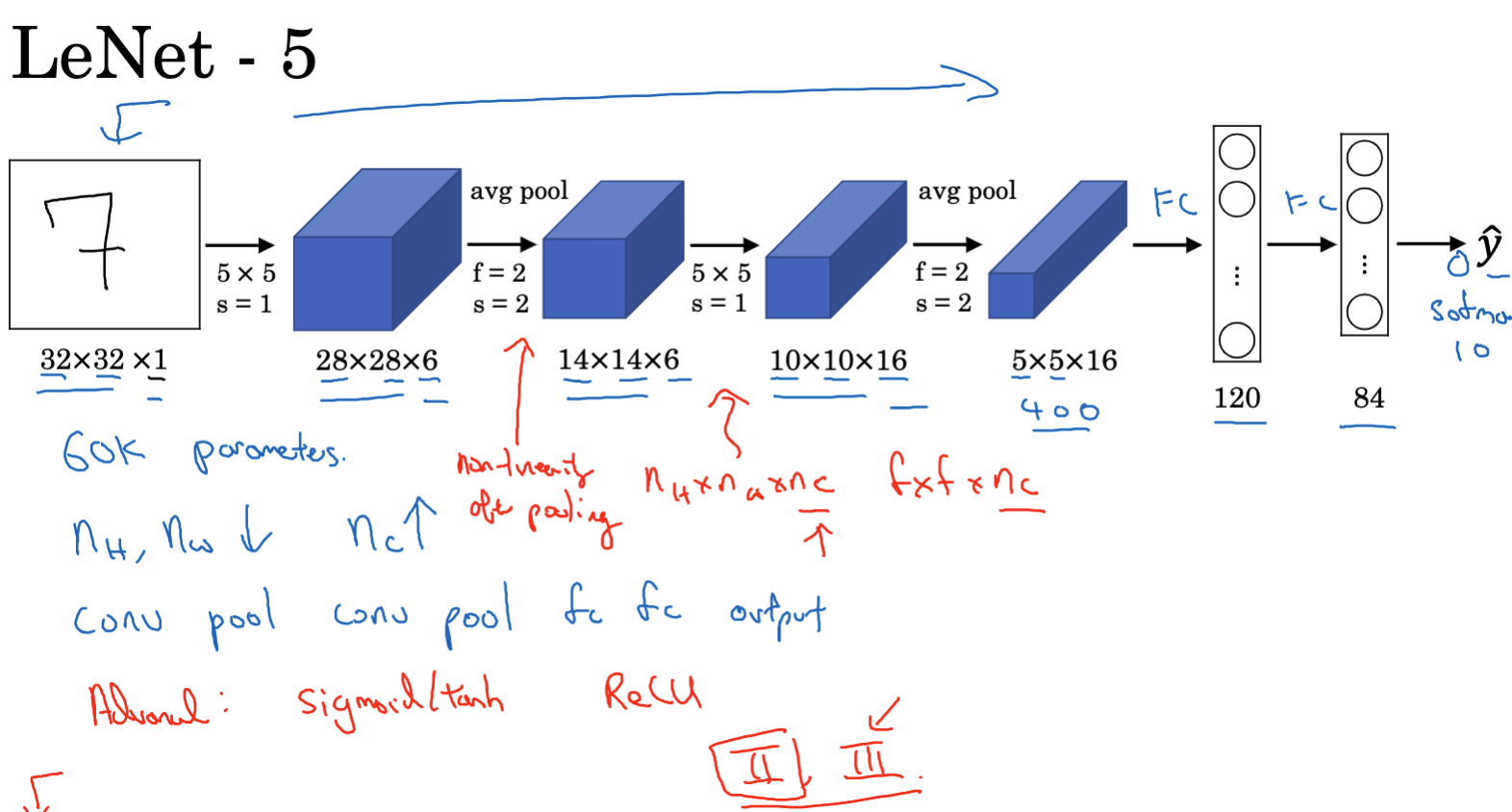

在深度学习快速发展的时代,各种创新型的神经网络架构层出不穷。要想跟着时代的发展,对于这些案例的研究是很有必要的。本篇博客将基于Andrew Ng教授的深度学习专项课程第四门课程的第二周内容来针对卷积神经网络的一些案例进行介绍。 案例研究的意义 首先思考一个问题,我们为什么需要研究这些案例呢? 首先,这些案例承载了前人在网络设计中积累的知识和经验。通…

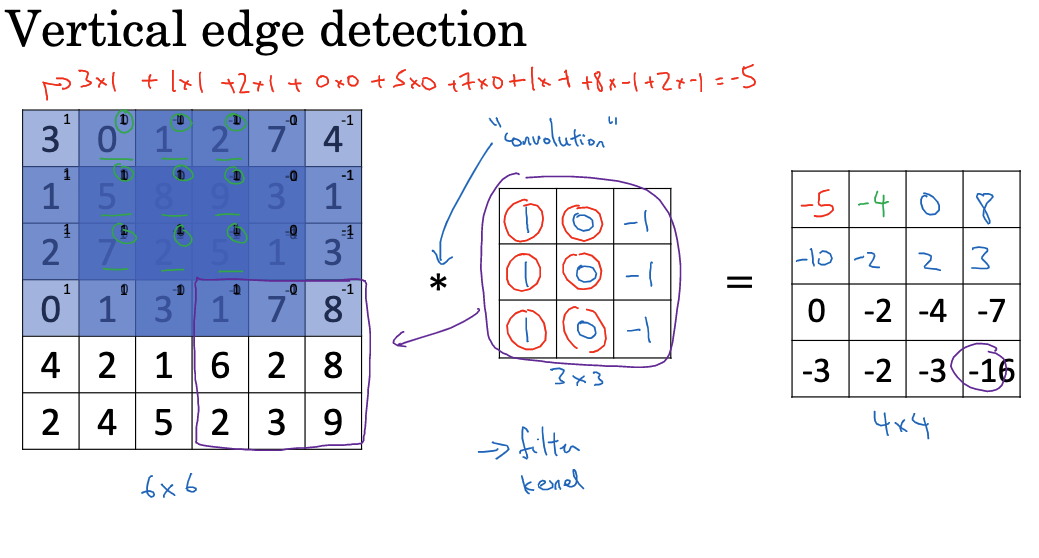

卷积神经网络(Convolutional Neural Network,简称CNN)是一类用于图像处理的深度神经网络。CNN借鉴生物视觉系统的结构,使用卷积运算提取图像的空间特征,再结合全连接层进行分类或预测。由于卷积运算的引入,CNN在图像处理方面表现卓越,被广泛应用于图像分类、目标检测、语义分割等任务中。本篇博客将基于Andrew Ng教授的深度学习专项课程第四门课程的第一周内容来针对卷积神经网络的基础知识进行简单的介绍。

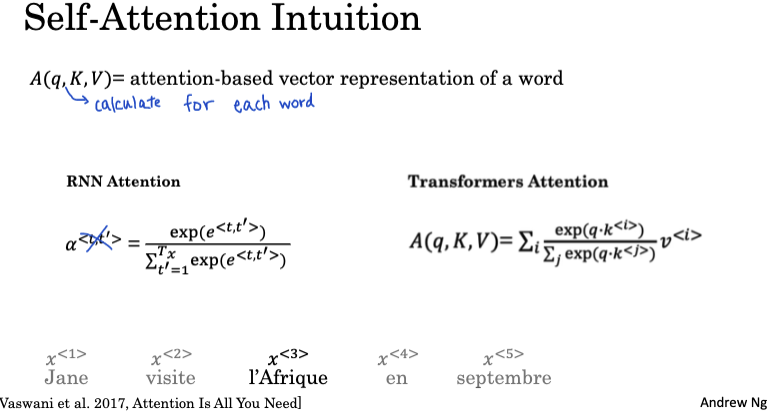

终于到序列模型课程最后一周的内容了,本篇博客依然是基于Andrew Ng的深度学习专项课程的序列模型来编写的,本篇内容不会很多,主要就是Transformer网络相关的知识点,Transformer网络是一种基于注意力机制的神经网络架构,被广泛应用于自然语言处理领域,尤其是机器翻译任务中。本文将详细介绍Transformer网络的关键概念和工作原理…

Sequence to Sequence Model是NLP领域非常核心的模型,这类模型使用编码器-解码器的结构,可以实现输入和输出不相同长度序列之间的变换。本篇博客将全面介绍序列到序列模型的基础概念、工作机制,尤其是其中注意力机制的技术更是当前大模型技术的根基之一,最后也会捎带介绍一些序列模型在语音处理的应用。本文也是基于Andrew Ng教授D…

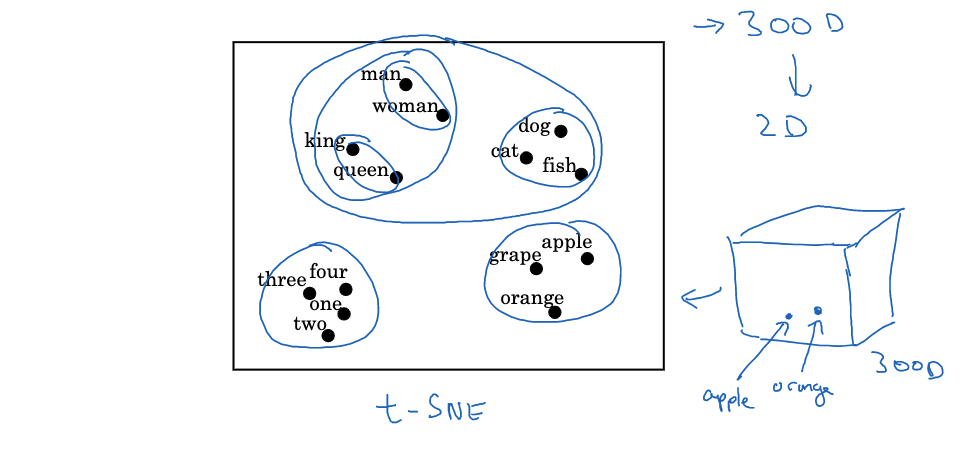

词嵌入(Word Embeddings)是自然语言处理(NLP)和深度学习中的一个核心概念。它通过将词汇映射到连续的向量空间,为计算机提供了一种直观和强大的方式来理解语言。本篇博客基于Andrew Ng教授的Deep Learning 专项课程中序列模型这门课第二周的内容,那我们开始吧! Word Embeddings 介绍 词嵌入的概念 词嵌入是…

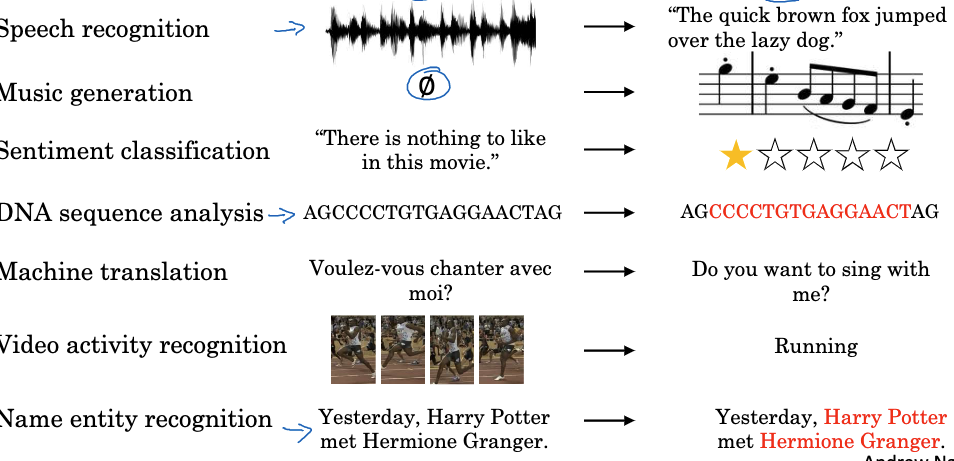

循环神经网络(Recurrent Neural Network, RNN)是一种能够处理序列数据的神经网络,在自然语言处理、语音识别、手写识别等领域发挥着重要作用。相比普通的前馈神经网络,RNN可以捕捉时间序列数据中的时序信息和长距离依赖关系。本篇博客将详细介绍RNN的工作原理、常见模型如门控循环单元(GRU)、长短期记忆(LSTM)以及如何应用于…