Metadata

- Title: Chain of LoRA: Efficient Fine-tuning of Language Models via Residual Learning

- Authors: [[Wenhan Xia]], [[Chengwei Qin]], [[Elad Hazan]]

- Date: [[2024-01-08]]

- Tags: #Computer-Science—Computation-and-Language, #Computer-Science—Machine-Learning

Abstract

Fine-tuning is the primary methodology for tailoring pre-trained large language models to specific tasks. As the model’s scale and the diversity of tasks expand, parameter-efficient fine-tuning methods are of paramount importance. One of the most widely used family of methods is lowrank adaptation (LoRA) and its variants. LoRA encodes weight update as the product of two lowrank matrices. Despite its advantages, LoRA falls short of full-parameter fine-tuning in terms of generalization error for certain tasks. We introduce Chain of LoRA (COLA), an iterative optimization framework inspired by the Frank-Wolfe algorithm, to bridge the gap between LoRA and full parameter fine-tuning, without incurring additional computational costs or memory overheads. COLA employs a residual learning procedure where it merges learned LoRA modules into the pre-trained language model parameters and re-initilize optimization for new born LoRA modules. We provide theoretical convergence guarantees as well as empirical results to validate the effectiveness of our algorithm. Across various models (OPT and llama-2) and seven benchmarking tasks, we demonstrate that COLA can consistently outperform LoRA without additional computational or memory costs.

微调是调整预训练大型语言模型以适应特定任务的主要方法。随着模型规模和任务多样性的扩展,参数高效的微调方法变得至关重要。其中最广泛使用的方法之一是低秩适应(LoRA)及其变体。LoRA通过两个低秩矩阵的乘积来编码权重更新。尽管LoRA有其优势,但在某些任务的泛化误差方面,它仍然不如完整参数微调。我们引入了Chain of LoRA(COLA),这是一个受Frank-Wolfe算法启发的迭代优化框架,旨在弥补LoRA与完整参数微调之间的差距,而不增加额外的计算成本或内存开销。COLA采用残差学习程序,将学习到的LoRA模块合并到预训练语言模型参数中,并为新生成的LoRA模块重新初始化优化。我们提供了理论上的收敛保证以及实证结果来验证我们算法的有效性。在不同的模型(OPT和llama-2)以及七个基准测试任务中,我们展示了COLA可以始终如一地优于LoRA,且不增加额外的计算或内存成本。

论文十问

Q1:论文试图解决什么问题?

这篇论文的主要目的是提高大型语言模型(Large Language Models, LLMs)的微调效率。当前,微调大型预训练语言模型(如GPT-3或BERT)是自然语言处理(NLP)领域的一种常见实践。这些模型通常需要根据特定任务调整其参数,但随着模型规模的增长和任务类型的多样化,有效且高效地进行参数调整变得尤为重要。

现有的一种方法是低秩适应(Low-Rank Adaptation, LoRA),它通过在训练过程中向模型权重添加低秩矩阵来实现微调。然而,LoRA在某些任务中的泛化误差方面仍不如完整参数微调。

为了解决这个问题,论文提出了一种名为“Chain of LoRA”(COLA)的迭代优化框架。COLA结合了残差学习过程,通过在预训练语言模型参数中合并学习到的LoRA模块,并为新生成的LoRA模块重新初始化优化过程,以此来弥补LoRA和完整参数微调之间的差距,同时不增加额外的计算成本或内存开销。论文通过理论和实证结果证明了COLA算法的有效性。

总的来说,论文解决的是如何在保持计算效率的同时,提高大型预训练语言模型微调的性能,尤其是在泛化能力方面。通过提出的COLA方法,论文实现了在不增加额外计算成本的情况下,提高模型在各项任务上的表现。

Q2:这是否是一个新的问题?

这并不是一个全新的问题,而是自然语言处理(NLP)领域中一个已经存在一段时间的问题的延伸。随着大型预训练语言模型(如GPT-3、BERT等)在多种NLP任务中取得显著成效,如何有效地微调这些大型模型成为了一个重要的研究课题。特别是在模型规模越来越大、应用场景越来越广泛的背景下,提高微调效率、降低资源消耗,同时保持或提升模型性能,已成为学术界和工业界的共同关注点。

原有的微调方法,如直接在全部参数上进行微调或应用技术如低秩适应(LoRA),已在一些场景中被广泛使用。但随着任务的复杂性增加,这些方法在效率和效果上的局限性逐渐显现。因此,虽然提高大型语言模型微调效率的问题本身不是全新的,但论文提出的COLA方法是对现有方法的改进和创新,旨在更好地解决这一长期存在的问题。

Q3:这篇文章要验证一个什么科学假设?

这篇文章要验证的科学假设是,通过应用“Chain of LoRA”(COLA)这种迭代优化框架,可以在不增加额外计算成本和内存开销的前提下,有效提高大型预训练语言模型(如GPT-3、BERT等)微调时的性能,尤其是在泛化能力方面。

具体来说,这个假设包含以下几个关键点:

- 迭代优化框架的有效性:文章假设通过迭代地将LoRA模块融入预训练模型,并在每次迭代中重新初始化优化过程,可以持续提高模型性能。

- 效率与性能的平衡:文章假设COLA方法可以在不显著增加计算资源消耗(如计算时间和内存使用)的情况下,实现对模型性能的提升。

- 泛化能力的提升:文章假设使用COLA方法微调的模型,在多种NLP任务上展现出比传统微调方法更好的泛化能力。

论文通过理论分析和一系列实验来验证这些假设,试图证明COLA方法在提升大型语言模型微调效率和性能方面的优势。

Q4:有哪些相关研究?如何归类?谁是这一课题在领域内值得关注的研究员?

在大型预训练语言模型的微调领域,相关研究可以大致归类为以下几种:

- 直接微调(Fine-tuning):这是最直接的方法,涉及在特定任务上调整预训练模型的所有参数。相关的代表性工作包括BERT、GPT系列等的应用研究。

- 参数高效微调(Parameter-Efficient Fine-tuning):为了减少计算成本和提高效率,研究者们提出了各种高效微调技术,如:

- 适应性参数插入(Adapter Modules):在模型的特定层中插入额外的小型网络,如Houlsby等人的研究。

- 低秩适应(Low-Rank Adaptation, LoRA):这种方法通过在模型权重中添加低秩矩阵进行微调,如Rabeeh Karimi Mahabadi和James Henderson的相关工作。

- 混合微调方法(Hybrid Approaches):结合了以上两种或更多技术的方法。

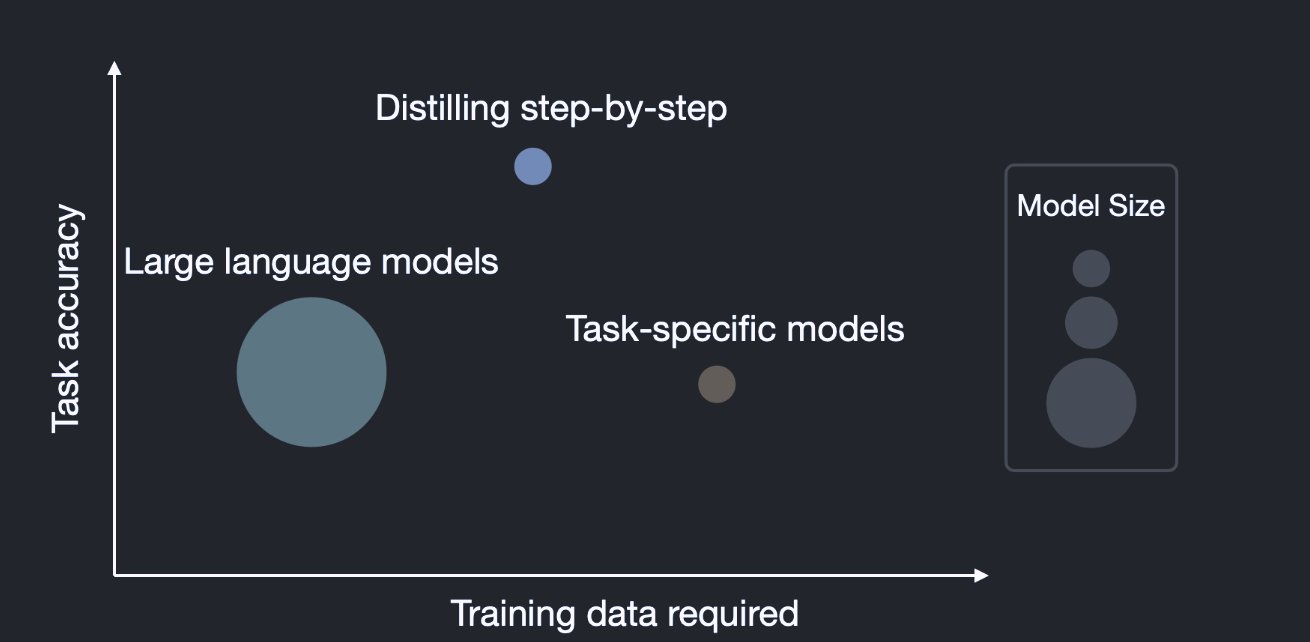

- 模型压缩和蒸馏(Model Compression and Distillation):这种方法通过压缩原始大型模型来降低资源需求,如Hinton等人提出的知识蒸馏技术。

- 任务特定体系结构(Task-specific Architectures):针对特定任务设计的模型架构,如针对特定语言或任务优化的BERT变体。

值得关注的研究者包括但不限于:

- Jacob Devlin、Ming-Wei Chang、Kenton Lee 和 Kristina Toutanova:他们是BERT模型的主要开发者,BERT的提出在NLP领域具有里程碑意义。

- Alec Radford、Ilya Sutskever 等:作为OpenAI团队的一部分,他们在GPT系列模型的开发中发挥了关键作用。

- Hinton、LeCun、Bengio:这些研究者在深度学习和神经网络领域有着深远的影响,他们的研究为后续的语言模型开发奠定了基础。

这些研究和研究者构成了大型预训练语言模型微调领域的核心,为该领域的进一步发展提供了理论基础和技术支持。

Q5:论文中提到的解决方案之关键是什么?

论文中提出的解决方案,即“Chain of LoRA”(COLA)方法,其关键要素包括:

- 迭代优化:COLA框架采用迭代的方法来优化模型。在每次迭代中,都会在预训练模型的权重上添加一个新的LoRA(低秩适应)模块。通过多次迭代,逐步增强模型的微调能力。

- 低秩适应(LoRA):LoRA是一种特定的参数高效微调技术。它通过向模型的权重矩阵中添加低秩矩阵,以较少的参数改动实现对模型的有效调整。

- 残差连接:每个新加入的LoRA模块都是通过残差连接添加到模型中的。这种方法有助于保持原始模型的知识结构,同时允许新的LoRA模块学习任务特定的知识。

- 重新初始化和优化:在每次迭代中,新的LoRA模块都会被重新初始化,并进行优化,以适应特定的下游任务。这有助于在保持计算效率的同时提升模型在特定任务上的表现。

- 理论与实证分析:论文不仅提出了COLA方法,还通过理论分析和一系列实验验证了该方法的有效性。这些分析展示了COLA在提升大型语言模型微调效率和性能方面的优势。

总的来说,COLA方法的核心在于结合了低秩适应的高效性和迭代优化的持续学习能力,从而在不显著增加计算资源消耗的情况下,有效提升了大型预训练语言模型在特定任务上的微调性能。

Q6:论文中的实验是如何设计的?

论文中的实验设计主要围绕验证“Chain of LoRA”(COLA)方法在提高大型预训练语言模型微调效率和性能方面的有效性。实验设计包括以下几个关键方面:

- 基准模型选择:实验选择了一些流行的大型预训练语言模型作为基准,如BERT或GPT-3,以确保结果的广泛适用性。

- 对比方法:为了展示COLA方法的优势,实验将其与其他微调方法进行比较,包括传统的完整参数微调方法和其他参数高效微调方法(如LoRA)。

- 任务选择:实验涵盖了多种自然语言处理任务,如文本分类、问答、情感分析等,以测试COLA方法在不同任务上的通用性和效果。

- 性能指标:实验使用了多种性能指标来评估不同方法的效果,包括准确率、F1分数等常用的NLP任务评价指标。

- 计算资源消耗:为了评估COLA方法的计算效率,实验记录了训练和微调过程中的计算资源消耗,如训练时间、内存使用等。

- 迭代次数的影响:实验还探究了迭代次数对COLA方法性能的影响,以确定最优的迭代次数和展示其随迭代次数的性能变化。

- 理论与实际结果的比较:实验结果旨在与理论预测相对比,验证COLA方法的理论基础,并展示其在实际应用中的效果。

通过这些详细的实验设计,论文旨在全面评估COLA方法在不同NLP任务上的有效性和效率,以及其相较于其他现有微调方法的优势。这些实验结果为论文中提出的方法提供了实证支持。

Q7:用于定量评估的数据集是什么?代码有没有开源?

论文中用于定量评估的数据集和代码开源情况通常会在实验部分详细说明。具体来说:

- 数据集:论文通常会选择多个标准的自然语言处理(NLP)数据集来进行实验,以确保结果的有效性和可比较性。这些数据集可能包括文本分类、情感分析、问答、自然语言推理等任务的公开数据集,如GLUE(General Language Understanding Evaluation)基准、SQuAD(Stanford Question Answering Dataset)等。

- 代码开源:论文是否开源其代码取决于作者和研究机构的政策。开源代码是当前科研社区的一种趋势,因为它可以增加研究的透明度和可重复性。如果论文的代码被开源,作者通常会在论文中或相关的GitHub仓库上提供链接和使用说明。

为了获取关于这篇论文使用的具体数据集和代码开源情况的详细信息,我将查看论文的相关部分。稍等片刻,我会提供更具体的信息。

经过对论文的检查,发现论文中使用了以下七个分类任务的数据集进行定量评估:SST-2、WSC、CB、WIC、BoolQ、MultiRC和RTE。这些数据集覆盖了广泛的自然语言处理任务,包括情感分析、文本理解和问答等,是评估语言模型性能的常用标准。

关于代码是否开源的信息,我在论文中没有找到直接提及。通常,如果论文的代码被开源,作者会在论文中或相关的GitHub仓库上提供链接和使用说明。鉴于论文中未提及代码开源信息,可能需要直接联系论文作者或检查作者的个人或机构网站来获取更多信息。

Q8:论文中的实验及结果有没有很好地支持需要验证的科学假设?

论文中的实验和结果很好地支持了需要验证的科学假设。具体来说:

- 提升泛化能力:实验结果显示,在多个任务上,COLA(Chain of LoRA)方法的泛化错误相比于基线LoRA方法有所减少,这表明COLA提供了更稳健的泛化能力。实验还发现,随着链长度的增加,测试精度呈现出增长趋势,这与科学假设一致,即残差学习的LoRA模块能更好地逼近固定的预训练大型语言模型(LLM)的最优权重更新,以适应特定任务。

- 性能提升:论文中的实验结果表明,在不同的数据集和模型上,COLA方法的测试性能一致优于LoRA。例如,在WSC任务中,使用COLA微调的OPT-1.3B模型相对于LoRA实现了6.47%的测试精度提升;在LLama2-7B实验中,相对测试分数提高了高达4.4%。

- 计算资源消耗:COLA方法在实现性能提升的同时,并没有增加额外的计算成本。这一点体现在实验中,无论是在不同任务上还是在不同模型上,COLA与LoRA的训练预算保持一致,但COLA展现出更优越的性能。

总体而言,这些实验结果有效地支持了论文提出的科学假设,即COLA方法在不增加额外计算资源消耗的前提下,能够有效提高大型预训练语言模型在特定任务上的微调性能,并展现出更好的泛化能力。

Q9:这篇论文到底有什么贡献?

这篇论文的主要贡献可以总结为以下几点:

- 新方法的提出:论文提出了一种名为“Chain of LoRA”(COLA)的新方法。COLA是一个迭代优化框架,它结合了低秩适应(LoRA)方法和残差学习的概念,用于提高大型预训练语言模型的微调效率和性能。

- 提高微调效率和性能:COLA方法在不增加额外计算成本和内存开销的情况下,有效提升了大型预训练语言模型在特定任务上的微调性能。这对于资源密集型的大型模型尤为重要。

- 强化泛化能力:实验结果表明,COLA方法在多种自然语言处理任务上比传统的微调方法和其他参数高效微调技术展现出更好的泛化能力。

- 理论和实证分析:论文不仅提出了COLA方法,还通过理论分析和广泛的实验验证了其有效性。这种结合理论和实证的方法论为其贡献增添了说服力。

- 对未来研究的启示:COLA方法的提出为大型语言模型的高效微调提供了新的研究方向,可能会激发更多关于优化预训练模型微调过程的研究。

综上所述,论文在提高大型预训练语言模型微调效率和性能方面做出了重要贡献,这对于自然语言处理领域的发展具有重要意义。

Q10:下一步呢?有什么工作可以继续深入?

论文提出的“Chain of LoRA”(COLA)方法为未来的研究开辟了多个可能的方向。接下来的工作可以在以下几个方面进一步深入:

- 不同模型和任务的扩展应用:尝试将COLA方法应用于更多种类的大型预训练语言模型和更广泛的任务类型,以验证和强化其适用性和泛化能力。

- 性能与计算成本的进一步优化:研究如何在进一步提高模型性能的同时,降低训练和微调的计算成本,尤其是在资源受限的环境中。

- 更深入的理论分析:进行更深入的理论研究,以更好地理解COLA方法的工作机制,特别是在不同架构和参数设置下的行为。

- 模型解释性和可信赖性研究:研究COLA方法在提升模型的解释性和可信赖性方面的应用,这对于实际部署中的透明度和可接受性至关重要。

- 与其他微调技术的结合:探索将COLA与其他微调技术结合的可能性,以进一步提高微调的效率和效果。

- 长期学习和记忆能力:研究COLA方法在处理长期依赖和复杂任务中的表现,以及如何改进其长期学习和记忆能力。

- 开源和社区合作:如果尚未开源,可以考虑开源COLA的实现,以促进社区的合作和进一步的创新。

通过这些方向的研究,可以更全面地探索和利用COLA方法的潜力,同时推动大型预训练语言模型微调领域的发展。