原书地址:https://udlbook.github.io/udlbook/ 人工智能(AI)旨在打造模仿智能行为的系统。它覆盖了众多方法,涵盖了基于逻辑、搜索和概率推理的技术。机器学习是 AI 的一个分支,它通过对观测数据进行数学模型拟合来学习决策制定。这个领域近年来迅猛发展,现在几乎(虽不完全准确)与 AI 同义。 深度神经网络是一类机器学习…

2023 的最后一个周末,也是今年的最后一天,之前说自己要做到周更,虽然本周也整了篇新文章,也是2024 年给自己埋的新坑,但感觉作为一年的最后一天,应当写一点总结性的东西比较合理。 今年都干了些啥 今年开始算是正式重启公众号的更新了,上一次还是去年5月份,而且之前Java和AI的文章五五开,今年一篇Java相关的文章都没写,全是AI了,感觉粉丝也…

OpenAI在自己的官方网站上之前发布了关于如何进行提示工程的指导文档,这份文档可以帮助我们更好的对AI发起提问,从而得到更有效的答案。以下是针对原文的翻译,主要使用ChatGPT4进行机翻,人工也会做一些微调,主要排版做了一点调整,此外有一些翻译不准确的地方请多见谅,但也希望大家看看原文,一起学习。本文主要提供的六个策略我这里直接列出来,方便大家…

不久前,NeurIPS 官方公布了 2023 年度的获奖论文,其中时间检验奖颁发给了10年前的论文「Distributed Representations of Words and Phrases and their Compositionality」。这篇论文可以看做是Word2Vec的第二篇论文。第一篇是「Efficient Estimatio…

最近因为有事没事就看看论文,虽然现在有GPT的帮助能提升不少效率,但其实对于一个科研小白而言还是非常吃力的。今天分享两个阅读论文的方式,一个是2007年就发表过的S. Keshav的How to Read a Paper,另一个是沈向洋博士提出的论文十问。相信已经有很多做科研的同学们都已经对看论文很熟练了,但对于刚开始入门的同学而言,这两个论文阅读…

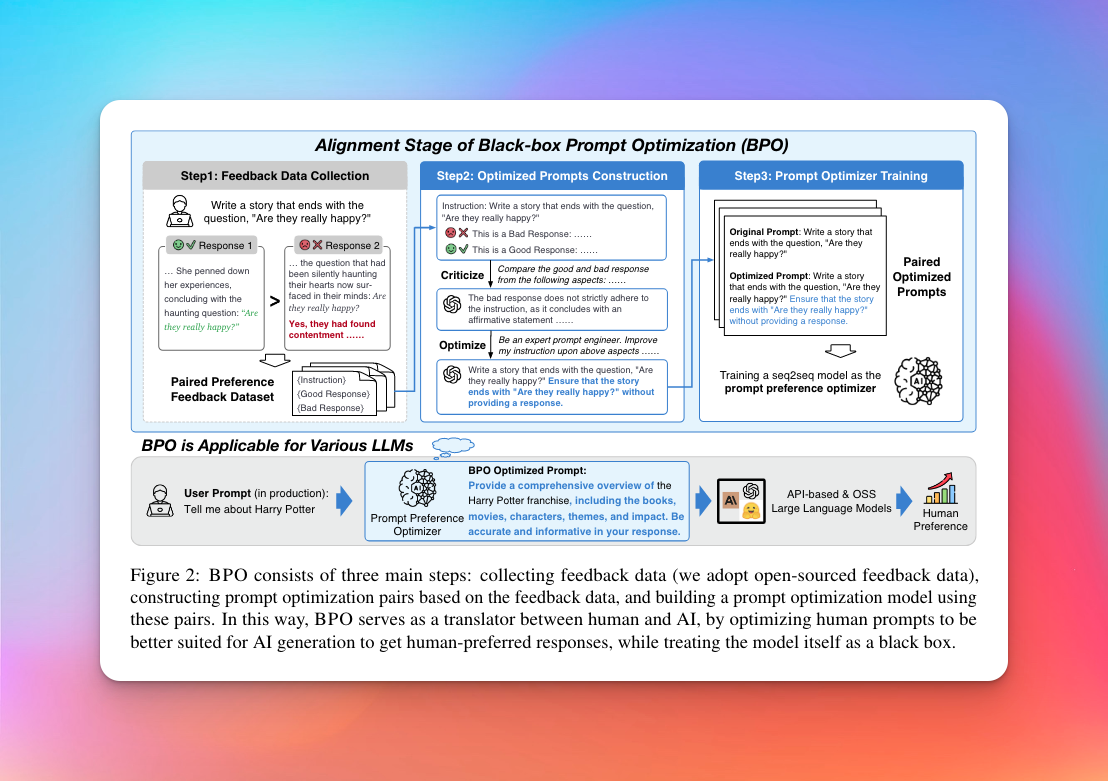

长期潜水在各个LLM技术群的小透明今天看到了智谱AI和清华团队又整了一篇有意思的论文,叫做Black-Box Prompt Optimization: Aligning Large Language Models without Model Training 主要是解决大模型的"对齐问题"。 啥叫对齐问题呢?指的是确保人工智能(…

今天又看了一篇好玩的关于RAG玩法的论文,叫做 SELF-RAG: LEARNING TO RETRIEVE, GENERATE, AND CRITIQUE THROUGH SELF-REFLECTION 。 核心思想很有意思,让LLM自己对自己说的话反思反思(脑海里不由得就想起前不久某知名主播说的让我们反思的话了)。接下来我就大致介绍一下这个方法…

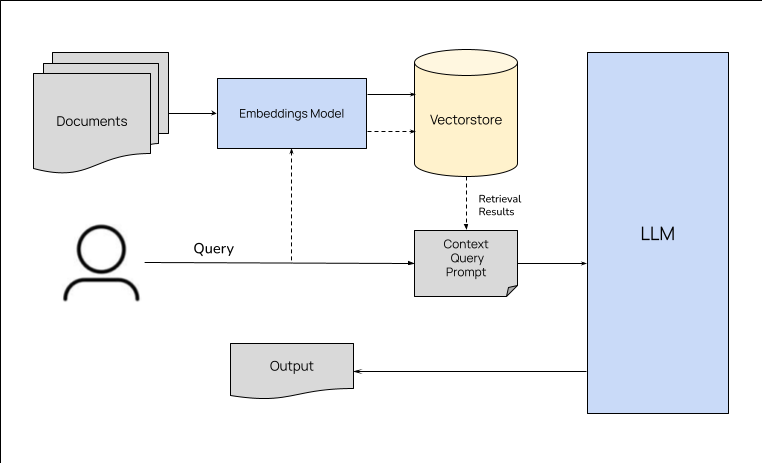

今天看了一篇来自于llmstack的创始人及CTO写的关于RAG的文章,正好最近在研究怎么玩本地知识库来着,感觉这篇文章很有帮助,这里翻译一下分享给大家,不过有时间的话更建议大家去看原文。 什么是检索增强生成? 如果你一直在向量存储或其他数据库中查找数据,并在生成输出时将相关信息作为上下文传递给 LLM,那么你已经在进行检索增强生成了。检索增强生成…

最近在研究如何将大语言模型结合本地知识库进行问答,虽然网上已经有很多教程,但大部分都是基于LangChain进行文本分割,然后调用模型向量化的API。这种方式的确很简单,但有这么几个前提: 大模型不使用ChatGPT的话,其实效果很差 尽管有多重切分方式,但还是很容易把文档中的一些语义撕裂。 由于众所周知的原因,使用ChatGPT的embeddin…

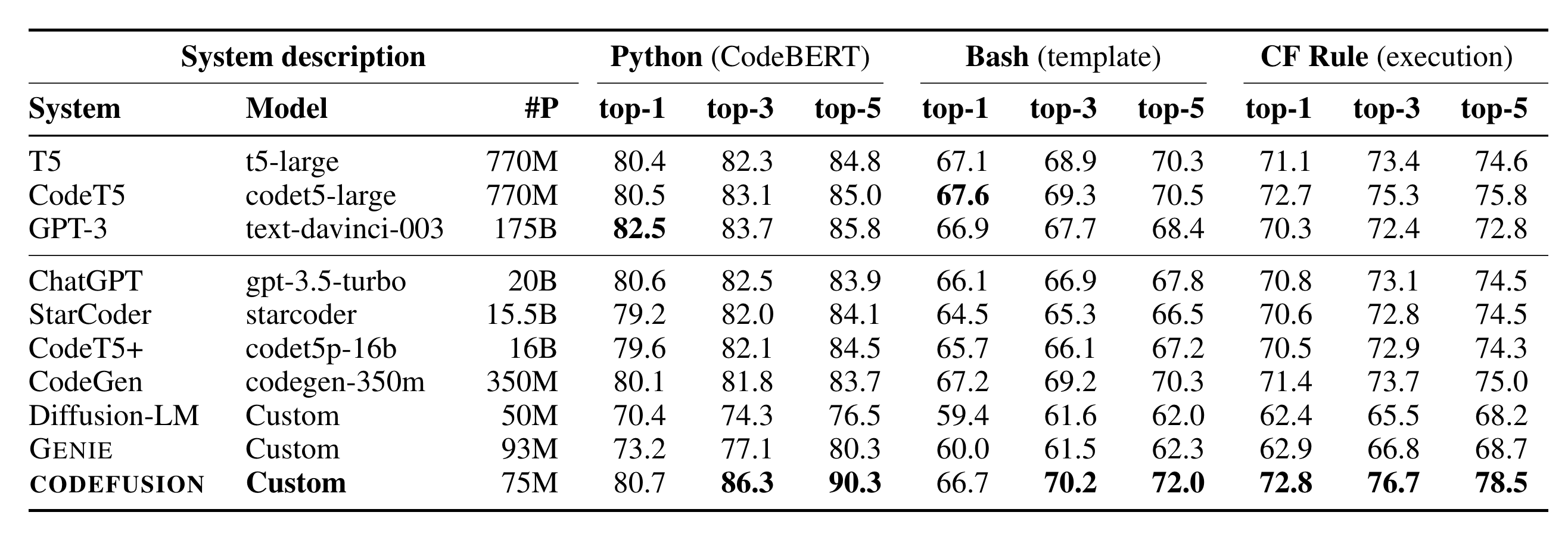

微软在10.26日发表了一篇论文CODEFUSION: A Pre-trained Diffusion Model for Code Generation,主要内容是提出了一个叫做CodeFusion的模型,它是一个基于扩散模型的从自然语言到代码生成模型,相对于论文提到的这个模型,更劲爆的是论文中的一张表格:看到图中的System descript…